本站 RSS地址已更新,麻烦读者朋友们重新订阅一次喔!

自从GPT-3.5爆发以来,短短一年多的时间,大模型的应用从极客圈扩展到更广泛的人群。从我的切身体验来看,技术的应用范围逐渐拓宽,越来越多的设备和应用开始在细节上体现出这些技术的融合。

变化的领域

翻译

最直观的变化体现在翻译领域。从视频字幕、多语言书籍翻译到音频和视频内容,语言的障碍几乎消失。

开发者们也热衷于推出各种应用,解决不同场景中的翻译需求。例如视频字幕翻译和书籍翻译,新软件的出现让普通用户几乎可以通过一键操作获得满意的翻译结果。

能用新的工具去看到更多文化,也是一种技术进步的红利。

编程助手

另一个变化明显的领域是编程辅助。随着模型能力的提升,像Cursor和GitHub Copilot这样的工具,已从最初的小段代码补全发展到可以帮助编写小型模块的代码。

作为计算机背景的产品人,虽然我的代码能力有限,但有一些研发经验,知道功能的基本组成。AI助手在这方面成为了很好的工具,帮助我编写小功能和工具,整个使用体验就很nice。

最令人惊喜的是,新技术能更方便实现web开发,通过游览器插件和本地web网页的形式,更好地解决需求。不用去学一堆配套的技术才能把东西做出来。

写作助手

写作是我期望AI能够帮助我的一个重要场景,但在这个领域,AI的帮助相对有限。目前,它只能提供一些信息作为写作参考,帮忙润色下文章的表达。

如果要达到类似代码补全的效果,AI需要更深入理解语义,才能提供更具价值的建议。但现阶段,它还做不到。

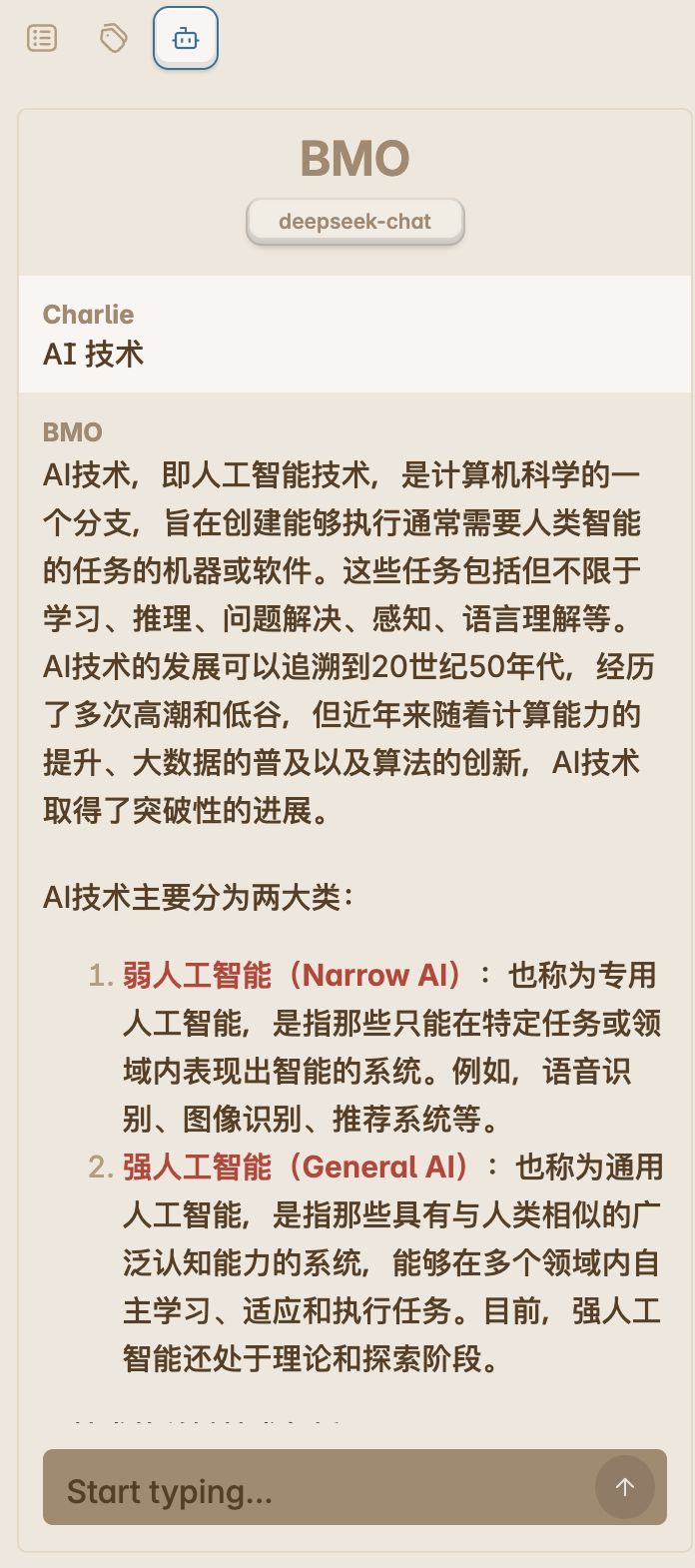

(上图是使用Obsidian的BMO插件,可以配置API使用云端大模型)

服务形式

本地大模型

基于设备端侧的本地模型应用,其中最出名的莫过于Ollama,我也写过一篇使用教程:Ollama 本地大模型部署教程

好处:快捷,不受网络影响 坏处:某些翻译不够精准,毕竟模型规模才7B

(上图是使用Ollama的qwen2.5模型翻译)

未来几年,硬件厂商可能会将更小的模型集成到设备中,让用户几乎无感地享受AI服务。那时,AI才能算是真正融入我们的生活。

云端模型

目前云端模型的服务商通常提供网页UI和API,针对普罗大众和技术开发者。经过一年的发展,这些厂商们开始通过应用的方式,把AI功能嵌入设备里,如ChatGPT的Mac客户端,只需按下快捷键即可呼出小对话框并获取答案。

(上图是ChatGPT的Mac客户端)

未来几年,云端模型将提供更加简洁的提示词、更精准的答案以及更多形式的内容输入(如图片、音频、视频)。目前,这些媒介内容更多是作为大模型的输入数据,用户的反馈体验尚未达到理想状态。

幻觉问题

幻觉问题仍然存在,但已有所改善。我们在使用前需要调整好心理预期,模型的作用是帮助收集和总结信息,节省时间,结果并不一定百分之百精准。不要把精力浪费在讨伐大模型的准确率上,错过真正有价值的东西。

各大厂商也在优化结果的准确性,以提高可信度。可以预见,未来几年,幻觉问题会逐渐缓解,也许有一天我们能完全信任AI的建议,那时AGI(通用人工智能)将正式进入我们的生活。

未来

过去的一年里,我持续高频使用AI技术,并逐渐摸清了大模型的能力边界。了解它能做什么非常重要,在技术框架内进行创作,可能会成为我们的新常态。

保持开放,持续迭代,拥抱变化,祝你开心!感谢你的时间!

💡 感谢您的观看!欢迎分享文章,或是来信与我交流。

付之一笑

付之一笑